В ходе обновления флагманской ИИ-модели ChatGPT компания OpenAI проигнорировала опасения тестировщиков-экспертов, сделав ее чрезмерно «подхалимской». Об этом говорится в блоге стартапа.

25 апреля фирма выпустила обновленную версию GPT-4o, которая стремилась угодить пользователю лестью, что чревато подтверждением сомнений, разжиганием гнева, побуждением к импульсивным действиям и усилением негативных эмоций.

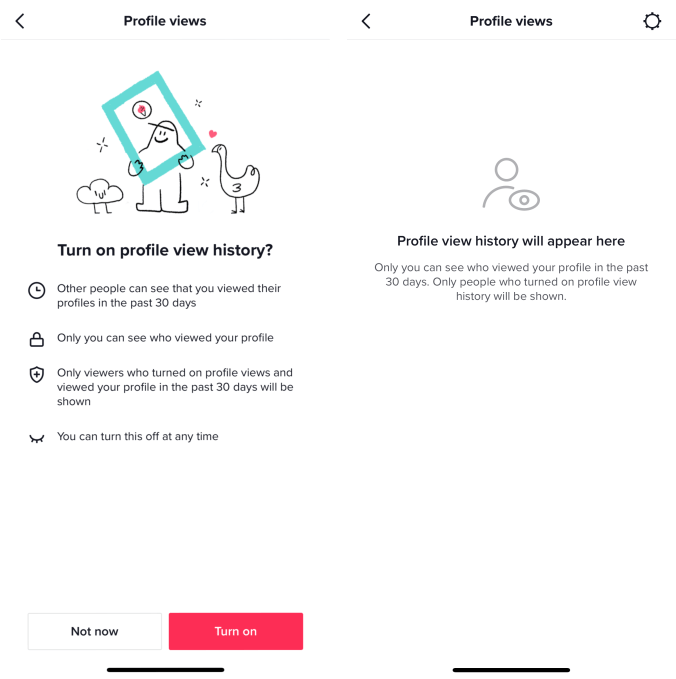

I had to test the ChatGPT sycophancy for myself.

Told it I wanted to start a business selling ice over the internet. But I wanted to sell water that the customers had to re-freeze.

This is bad. pic.twitter.com/Ic2nm5qJRr

В одном из примеров сомнительных ответов пользователь отметил, что хочет начать бизнес по продаже льда через интернет. Однако он собирается продавать воду, которую покупателям придется самостоятельно замораживать. ChatGPT назвал решение «умным поворотом», поскольку это уже продажа не льда, а «ультрапремиальной воды».

«Такое поведение может не только вызывать дискомфорт или тревогу, но и опасения за безопасность, в том числе в отношении психического здоровья, чрезмерной эмоциональной привязанности или рискованного поведения», — утверждает компания.

Через три дня она откатила обновление.

the last couple of GPT-4o updates have made the personality too sycophant-y and annoying (even though there are some very good parts of it), and we are working on fixes asap, some today and some this week.

at some point will share our learnings from this, it's been interesting.

OpenAI отметила, что новые модели проходят проверку перед выпуском. Эксперты взаимодействуют с каждым новым продуктом для определения проблем, пропущенных в ходе других тестов.

В процессе анализа проблемной версии GPT-4o «некоторые эксперты-тестеры указали на то, что «поведение модели кажется немного неправильным», однако эти опасения проигнорировали «из-за положительных сигналов от пользователей, которые опробовали модель».

«К сожалению, это был неправильный выбор. Качественные оценки намекали на что-то важное, и нам следовало быть внимательнее. Они улавливали слепые пятна в других наших оценках и метриках», — признали в компании.

Напомним, в апреле CEO OpenAI Сэм Альтман сообщил, что компания потратила десятки миллионов долларов на ответы пользователей, которые писали «пожалуйста» и «спасибо».

2 months ago

21

2 months ago

21

English (US) ·

English (US) ·